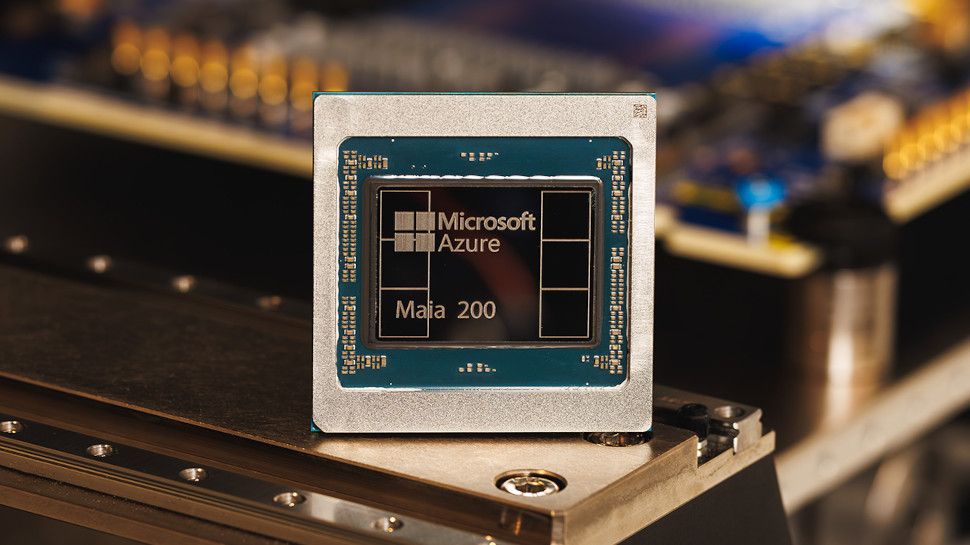

- Microsoft ha presentado el hardware de IA Maia 200

- Según se informa, Maia 200 ofrece mayor rendimiento y eficiencia que los competidores de AWS y GCP

- Microsoft lo utilizará para desarrollar Copilot internamente, pero también estará disponible para los clientes.

Microsoft ha lanzado Maya 200, su “próximo gran hito” en el soporte de la tecnología de inferencia e inteligencia artificial de próxima generación.

El nuevo hardware de la compañía, el sucesor del Maia 100, “cambiará drásticamente la economía de la IA a gran escala”, ofreciendo una mejora significativa en el rendimiento y la eficiencia que exige el mercado.

El lanzamiento impulsará a Microsoft Azure como un gran lugar para ejecutar modelos de IA de manera más rápida y eficiente, mientras busca enfrentarse a sus archirrivales Amazon Web Services y Google Cloud.

Microsoft Maya 200

Microsoft dice que el Maia 200 tiene 100 mil millones de transistores construidos en el proceso TSMC de 3 nm con núcleos tensores nativos FP8/FP4, un nuevo sistema de memoria con 216 GB HBM3e a 7 TB/s y 272 MB de SRAM en el chip.

Todo esto contribuye a la capacidad de ofrecer más de 10 PFLOPS de precisión de 4 bits (FP4) y casi 5 PFLOPS de rendimiento de 8 bits (FP8), con suficiente facilidad para ejecutar los modelos de IA más grandes de la actualidad y a medida que el espacio crece a medida que evoluciona la tecnología.

Microsoft dice que Maya 200 ofrece 3 veces el rendimiento FP4 del hardware Amazon Trenium de tercera generación y el rendimiento FP8 sobre el TPU de séptima generación de Google, lo que lo convierte en el sistema de inferencia más eficiente de la compañía hasta el momento.

Y gracias a su diseño optimizado, que ve el subsistema de memoria centrado en tipos de datos de precisión estrecha, un motor DMA especial, SRAM integrada y un tejido NoC especial para el movimiento de datos de gran ancho de banda, Maia 200 es capaz de mantener una mayor parte del peso de un modelo y los datos locales, lo que significa que se necesitan menos dispositivos para ejecutar el modelo.

Microsoft ya está utilizando el nuevo hardware para impulsar sus cargas de trabajo de IA en Microsoft Foundry y Microsoft 365 Copilot, y próximamente habrá una mayor disponibilidad para los clientes.

Ahora está implementando Maya 200 en su región de centro de datos Central de EE. UU., y pronto habrá más implementaciones en su región de centro de datos US West 3, cerca de Phoenix, Arizona, y en regiones adicionales a continuación.

Para aquellos que buscan echar un vistazo temprano, Microsoft ahora invita a educadores, desarrolladores, Frontier AI Labs y contribuyentes de proyectos de modelos de código abierto a registrarse para obtener una vista previa del nuevo kit de desarrollo de software (SDK) Maia 200.

Siga TechRadar en Google News Y Agréganos como fuente preferida Recibe noticias, reseñas y opiniones de nuestros expertos en tu feed. ¡No olvides hacer clic en el botón de seguir!

Y por supuesto que puedes Siga TechRadar en TikTok Reciba nuestras actualizaciones periódicas en forma de noticias, reseñas, unboxing y videos. WhatsApp muy