- La APU GSI Gemini-i reduce la constante mezcla de datos entre el procesador y el sistema de memoria.

- Completa las tareas de recuperación un 80% más rápido que CPU comparables

- La APU GSI Gemini-II proporcionará diez veces más rendimiento

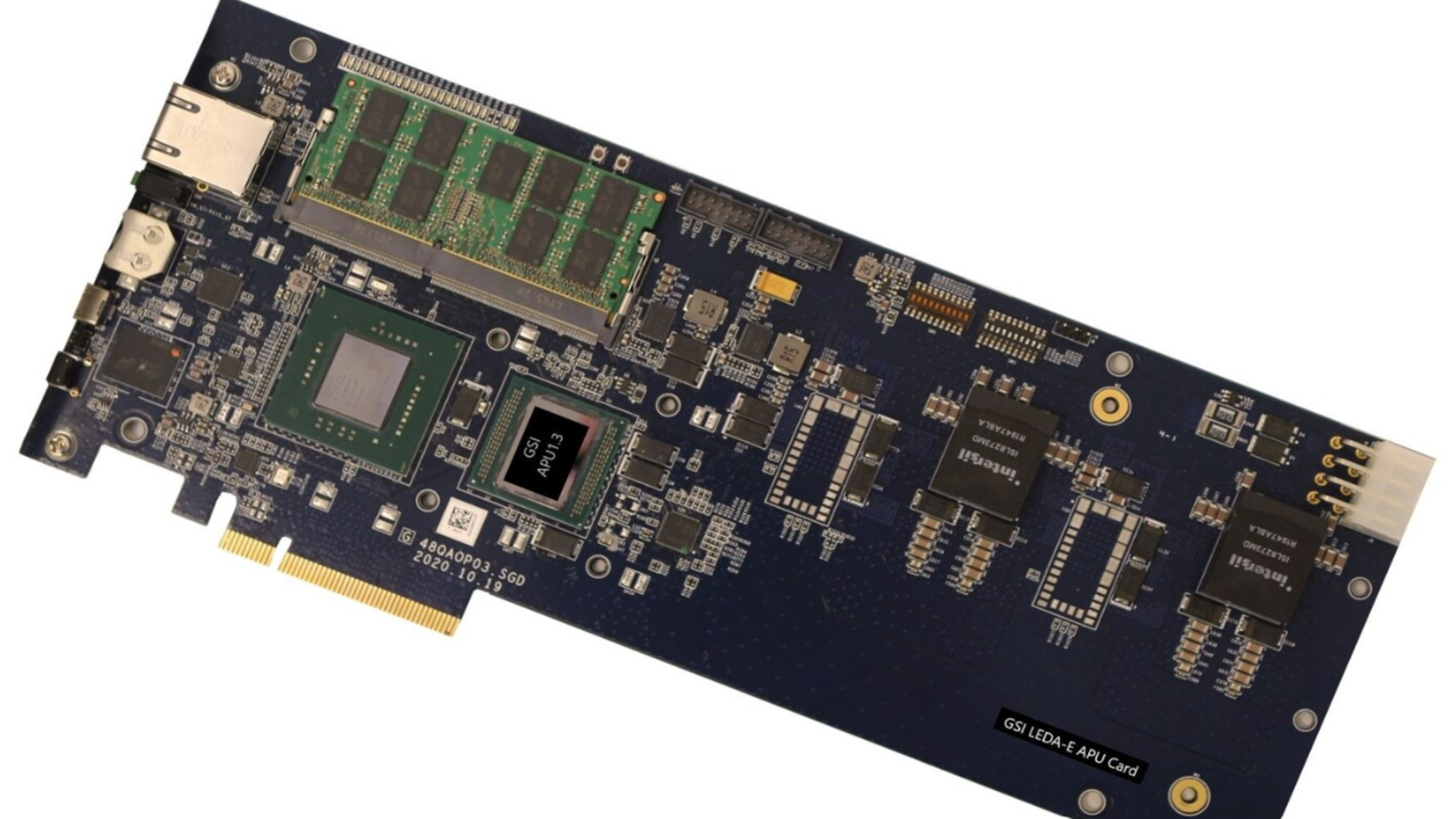

GSI Technologies está promoviendo un nuevo enfoque para el procesamiento de inteligencia artificial que computa directamente en la memoria.

Un nuevo estudio de la Universidad de Cornell llama la atención sobre este diseño, conocido como unidad de procesamiento asociativo (APU).

Su objetivo es superar los límites de rendimiento y eficiencia, lo que sugiere que podría desafiar el dominio de las herramientas de inteligencia artificial y las mejores GPU que se utilizan actualmente en los centros de datos.

Un nuevo competidor en hardware de IA

Publicada en el ACM Journal y presentada en la reciente conferencia Micro ’25, la investigación de Cornell evaluó la APU Gemini-I de GSI frente a CPU y GPU líderes, incluida la A6000 de Nvidia, utilizando cargas de trabajo de generación aumentada de recuperación (RAG).

Los experimentos abarcan conjuntos de datos de 10 a 200 GB, lo que representa condiciones realistas de inferencia de IA.

Al realizar cálculos en RAM estática, la APU baraja datos constantes entre el procesador y la memoria.

Esta es una fuente clave de pérdida de energía y latencia en las arquitecturas de GPU convencionales.

Los resultados muestran que la APU puede alcanzar un rendimiento de clase GPU utilizando mucha menos energía.

GSI informa que su APU consume un 98% menos de energía que una GPU estándar y realiza tareas de recuperación hasta un 80% más rápido que las CPU comparables.

Tal eficiencia podría hacerlo atractivo para dispositivos de vanguardia como drones, sistemas de IoT y robótica, así como para aplicaciones aeroespaciales y de defensa, donde los límites de energía y refrigeración son estrictos.

A pesar de estos resultados, aún no está claro si la tecnología de computación en memoria puede escalar al mismo nivel de madurez y soporte que disfrutan las mejores plataformas de GPU.

Actualmente, las GPU se benefician de ecosistemas de software bien desarrollados que permiten una integración perfecta con las principales herramientas de inteligencia artificial.

Para los dispositivos de computación en memoria, la optimización y la programación siguen siendo áreas emergentes que pueden frenar una adopción más amplia, especialmente en operaciones de grandes centros de datos.

GSI Technology dice que continúa perfeccionando su hardware, y se espera que ofrezca diez veces más rendimiento y menor latencia que la generación Gemini-2.

Se está desarrollando otro diseño llamado Plato para ampliar aún más el rendimiento informático de los sistemas de borde integrados.

“La validación independiente de Cornell confirma lo que hemos creído durante mucho tiempo: la computación en memoria tiene el potencial de alterar el mercado de inferencia de IA de 100 mil millones de dólares”, dijo Li-Lin Shu, presidente y director ejecutivo de GSI Technologies.

“La APU ofrece un rendimiento de clase GPU a una fracción del consumo de energía, gracias a su arquitectura centrada en la memoria altamente eficiente. Nuestro silicio APU de segunda generación recientemente lanzado, Gemini-II, puede ofrecer un rendimiento aproximadamente 10 veces más rápido y una latencia incluso menor para cargas de trabajo de IA con uso intensivo de memoria”.

a través de TechPowerUp

Siga TechRadar en Google News Y Agréganos como fuente preferida Recibe noticias, reseñas y opiniones de nuestros expertos en tu feed. ¡No olvides hacer clic en el botón de seguir!

Y por supuesto que puedes Siga TechRadar en TikTok Reciba nuestras actualizaciones periódicas en forma de noticias, reseñas, unboxing y videos. WhatsApp muy